En god SEO optimeret hjemmeside starter altid med en god platform. Hjemmesiden skal nemlig være nemt tilgængeligt for søgemaskiner. Den skal kunne læses (Crawl) nemt og have en rigtig god struktur. Når men kigger på den tekniske del af hjemmesiden så kigger man på nogle forskellige elementer.

Denne guide er fokuseret på at optimere til Google søgemaskine, der er mange ting der vil give en effekt på andre søgemaskiner da den arbejder under samme principper men da den guide er fokuseret på Google er det ikke den optimale guide for de andre søgemaskiner.

Googlebot som er den robot der læser hjemmesider fungerer på den måde at den læser en side, her vil den kigge efter forskellige ting. Den vil tjekke hvilket emne siden handler om, hvilken søgeord der kan bruges så den kan indekseres. Hvor mange sider peger på den side og så vil den læse alle links siden indeholder. Disse links vil så blive brugt til at blive læst og samme proces går igennem igen. Selvfølge sker der meget mere under kølerhjelmen men simplificeret er det hvordan den virker i bund og grund.

Så kan man forstille sig hvordan den efterhånden har dannet et web af hjemmesider som alle er forbundet sammen. Jo flere links der peger på en side jo mere er den populær og jo højere op skal den rankeres. Her er der flere kompliceret algoritmer så som relevansen af sidens indhold, relevansen og autoteten af links der peger, og om det er spammede links eller rigtige.

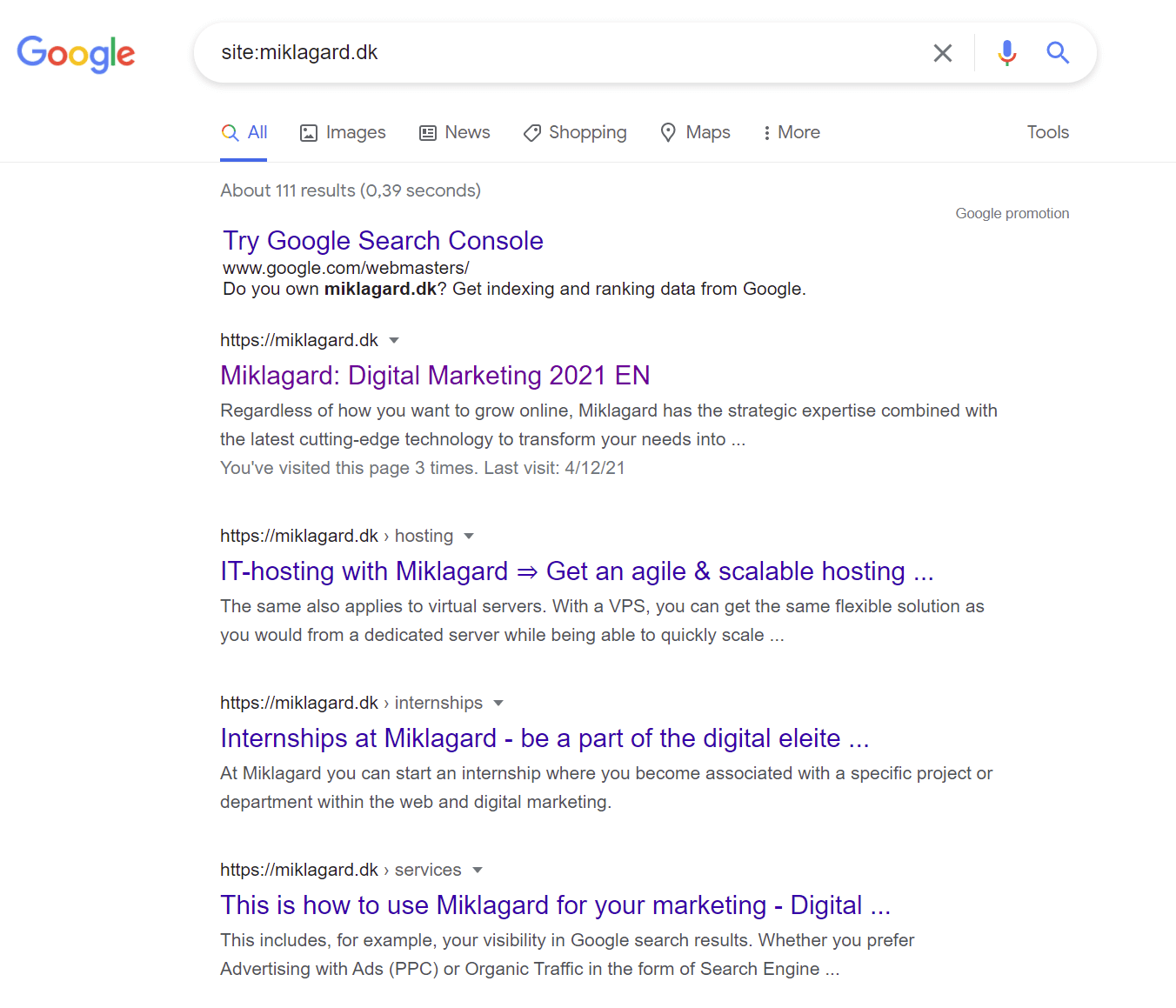

Det allerførste spørgsmål er selvfølge om Google kan finde din hjemmeside. Nemt at finde ud af det. Hvis du går ind på Google og skriver “site:din hjemmeside” hvor “din hjemmeside” er url på din hjemmeside uden https:// eller http:// så kommer din hjemmeside enten op eller ikke. Hvis den ikke gør betyder det at Google har svært ved at finde eller læse din side.

For at Google kan finde og læse din side skal der være et par ting på plads.

Det er stærkt anbefalet at man har en sitemap fil der indeholder alle url så at Google kan læse dem. En sitemap er en xml fil der ligger på roden og er navngivet “sitemap.xml”. Sitemap behøver ikke at være en xml fil men kan være TXT fil eller RSS. For at se dokumentationen på hvordan xml filen skal struktureres kan du besøge Google Developer her.

Hvis du bruger WordPress eller andre CMS-platform til at bygge din hjemmeside findes der nogle plugins der kan genere sitemap filen for dig. Yoast f.eks. er et plugin der kan gøre det for WordPress hjemmesider som er nemt at installere her en guide. Vore hjemmeside Miklagard bruger også Yoast til at genere sitemaps og den kan ses her.

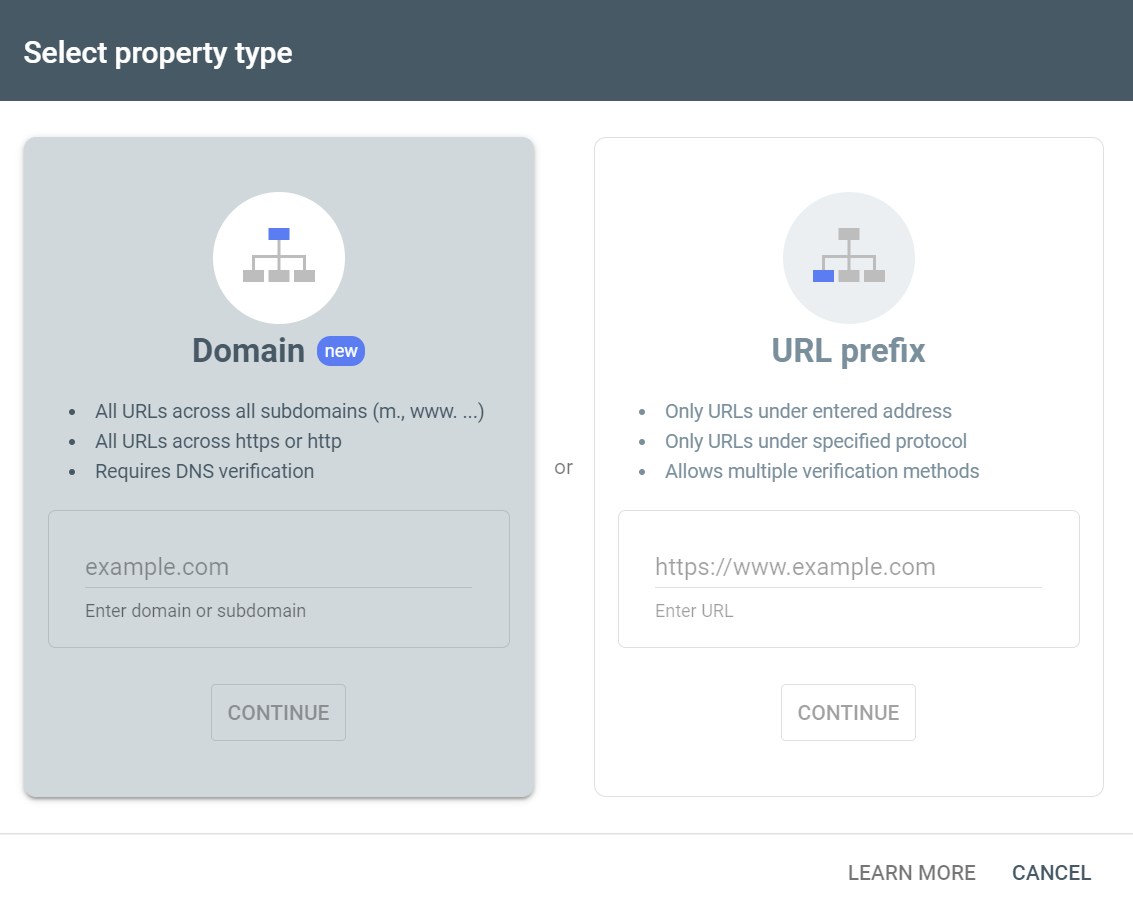

Når Google læser sitemap får den et hurtigt overblik over alle url på hjemmesiden, og når du har din sitemap lavet, så skal du indsende den til Google. Det gør du via Google Search Console. Du skal have en konto før du kan benytte den, men efter du har oprettet en konto så skal du tilføje din hjemmeside hvis du ikke allerede har. Det gør du ved at klikke på “Add property”.

Du skal derefter indtaste url'en på din hjemmeside, og verificere at du har adgang og er ejeren af hjemmesiden.

Når hjemmesiden er verificeret skal du vælge “Sitemaps” fra den venstre søjle.

Derefter skal du blot indtaste url’en for din sitemaps.

Der går noget tid før din hjemmeside bliver indekseret, og du kan tjekke om den viser ved at indtaste “site:URL PÅ DIN HJEMMESIDE”. Se hvordan vi kan se alle sider der er for miklagard.dk

Hvis din hjemmeside ikke dukker op når du søger på dit søgeord så er det fordi du stadig mangler at arbejde på din SEO-strategi. Lige nu har vi kun sikret et din hjemmeside kan ses af google men vi har ikke arbejde på din SEO endnu. For at du kan dukke op i toppen af resultater er der stadig langt vej og mere arbejde der skal til. Det er så de ting vi kommer til at gå igennem med den her guide så du kan arbejde på din side og komme frem og få mere synlighed.

En robot.txt fil ligger altid på roden af dit domain. Den fortæller Google hvilke sider den gerne må læse og hvilken den ikke må. Den er også meget vigtigt da den kan blokere Google robot fra at læse hjemmeside. I nogle tilfælde vil man gerne undgå at Google Crawler en side, og derfor skal der opsættes en regel i den fil. Vi henviser til Google Dokumentation på hvordan man laver denne fil.

Det skal siges at denne fil vil aldrig kunne blokere Google fuldstændigt da andre sider der peger kan stadig tillade Google at indeksere din side. Hvis hjemmeside skal blokeres helt er der andre metoder der skal blive brugt så som password beskyttelse.

Robot.txt filen kan også indeholde url til sitemap. Dette er dog ikke nødvendigt længere da sitemap bliver indsendt til google via Google Search Console. Her er et eksempel på en robot.txt fil

robot.txt

---------------------------

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Allow: /

Sitemap: http://www.example.com/sitemap.xml

---------------------------

Det først felt “User-agent" fortæller hvilket søgemaskine reglen skal gå til, her er det Google robotten. Derefter kommer reglen som fortæller at den skal ikke lade Google bot Crawle alt under roden “/nogooglebot/”.

“User-agent: *” fortæller at alle søgemaskiner med tegnet “*” og at de kan “Allow” læse hele hjemmesiden.

Til sidst er der en URL til sitemappen på siden.

Den er meget simpel at forstå, men det vigtigt at det er opsat korrekt og kan oftest blive overset.

Google giver hver side en bestemt tid hvor hvis den ikke når at blive færdigt så dropper den forbindelsen og går til den næste side. Derfor er det også ret vigtigt at optimere hastigheden på siden så at Google kan læse så mange sider på din hjemmeside som muligt og du får den bedste chance at komme frem på den søgemaskine.

Hjemmesidens hastighed kan altid tjekkes på Google Pagespeed Insights med dette værktøj som Google ligger tilgængeligt til alle her.

Selve denne proces kan være indviklet afhængigt af den hjemmeside der skal arbejdes på. Men for at gør det simpelt vil vi nævne nogle af den ting der kan øge hastigheden på hjemmesiden.

Det altid godt at have en hurtig server i første omgang, men har man en allerede godt kærende hjemmeside er en opgradering måske et godt sted at starte. En dedikeret server er altid hurtigere og bedre og kan øge hastigheden på hjemmesiden.

Der er mange billederne som ligger på en hjemmeside og de tager tid at hente. Især med mobile enheder kan det gær siden meget langsomt. Derfor skal man altid optimere alle billederne man ligger på hjemmesiden. Hvis billederne er for store kan de også nedskaleres så at de ikke fylder for meget før det optimeres.

Vi anbefaler man bruger TinyPNG til at optimere billederne. Det eneste man skal gære er at upload billedet man vil optimere til TinyPNG og den klar resten, derefter skal man hente den optimeret billede og uploadede den til hjemmesiden. Det kan øge hastigheden på helt op til 90%.

Caching er den proces hvor den server hjemmesiden ligger på ikke behøver at udarbejd den kode den skal sende til brugeren. Den er nemlig allerede cachet og gemt, og den skal blot bare send responsen tilbage, hvilket gør hjemmesiden meget hurtigere. Hvis man har et CMS-system så er det en god ide og noget vigtigt at man installer et cachingplugin. Hvis man bare har en statik side så behøver den ikke at blive cachet.

Sikkerhed er ekstremt vigtigt hvis man gerne vil komme frem på topresultaterne. Google vil gerne sende bruger til sikre hjemmesider, så hvis din side er usikker og ikke bruger HTTPS, så kommer en mere sikker side over dig på søgningerne hvis den findes.

Hvis du ser en “Not secure” når du besøger din hjemmeside så er det nok fordi din hjemmeside ikke har TLS og ikke køre over den sikre protokol HTTPS.

HTTPS bruger kryptering til at gøre forbindelsen mellem bruger og hjemmeside sikker. Protokollen den bruger hedder Transport Layer Security eller forkortet TLS. Hvis hjemmesiden ikke bruger TLS/SSL så er det nemt for andre at se alt der bliver sendt og dermed kan det være farligt at besøge disse sider.

Der er mange flere elementer til den tekniske del herunder skal der ikke være dødelinks på hjemmesiden. Derfor bruges værktøj så som AHREFs eller SEMRUSH til at tjekke om der er døde links som man skal fikse.

Døde links føre til en 404 ERROR-side, som fortæller brugeren at siden ikke findes længere. Hvis dette sker ses det som en dårlig oplevelse for en bruger og derfor skal det rettes.

Når Google læser en side, kigger de på noget der hedder “Meta Data” disse indeholder titlen på siden, en beskrivelse og søgeord. Søgeord er så udfaset nu og Google henter dem direkte fra sidens indhold.

Billeder har også alt tekst. Disse fortæller Google hvad det er billedet er til, og denne tekst er også vigtig så Google kan vise billederne på Google søgeresultater.

Din hjemmesider skal linke til hinanden så at en bruger kan hurtig navigere mellem de forskellige sider. Ligesom Wikipedia har en re vild intern link struktur er det vigtigt at linke til relevante sider. Det gør at hjemmesiden er stærk og har et solid intern link struktur hvilket hjælpe på at ranke alle de forskellige sider og hjælper Google robotten i at læse de forskellige sider.

Lige så vigtigt er det at link til en ny side med en REDRECT hvis den gamle side tages ned. Dette sikrer at man ikke mister den trafik siden allerede har og man kan lave en 301 REDIRECT til den nye side og fortælle google at siden har fået en ny url.

Google Search Console er din ven. Brug værktøjet da det er lavet af Google og bruges til at få en bedre ranking på Google. Du kan få meget input fra Google Search Console om hvad der kan være galt med din hjemmeside og hvis det ikke løses kan dine sider falde i rank.

Når der skrives indhold er det ikke en god ide at bare kopiere det fra en anden side. Google kan nemt se at indholdet ikke er originalt og siden vil ikke komme frem. Så det vigtigt man skriver indhold der originalt og at man ikke selv har to forskellige sider med samme indhold.

Miklagard Datadreven Webbureau SEO, PPC & Digital

All rights reserved Miklagard Group ApS 2021

CVR.nr: 40780068